ML v Pythone 7 – Využitie grafickej karty NVIDIA na výpočtovo náročné úlohy

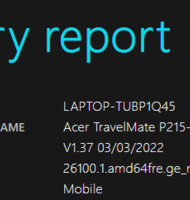

V predchádzajúcej časti sme ukázali vytvorenie animovaných grafov a export od videosúborov. V tejto časti predstavíme platformu CUDA (Compute Unified Device Architecture) ktorá využíva výkon grafických kariet NVIDIA na výpočtovo náročné úlohy. Vo videu je ukázaná inštalácia CUDA Toolkitu, a následne na príklade násobenia veľkých matíc funkciou z knižnice Torch je porovnaná rýchlosť výpočtu pomocou CPU a GPU

CUDA (Compute Unified Device Architecture) je softvérová platforma, ktorá využíva výkon grafických kariet NVIDIA na náročné úlohy, napríklad na úlohy strojového učenia, čo je náš prípad, ale aj na rendrovanie videa, ťažbu kryptomien a podobne. Výhody tejto platformy na lokálnom počítači samozrejme môžu využívať len tí, čo v PC, alebo notebooku majú grafickú kartu NV ...

Článok je uzamknutý

Prihlásiť pomocou členstva NEXTECH

Článok je uzamknutý

Pokračovanie článku patrí k prémiovému obsahu pre predplatiteľov. S digitálnym predplatným už od 10 € získate neobmedzený prístup k uzamknutému obsahu na celý rok. Objednať si ho môžete TU. Ak ho už máte prihláste sa TU

Prihlásiť pomocou členstva NEXTECH